Nel corso delle ultime settimane, molti webmaster iscritti al servizio Google Search Console sono stati avvisati via e-mail che “Googlebot non riesce ad accedere ai file CSS e JS” del loro sito. Il problema non è effettivamente da sottovalutare, ma come vedremo la soluzione è alla portata di tutti.

Prima di descrivere passo passo come porre rimedio, cerchiamo di fare chiarezza sul significato di questo messaggio, di capire quali siano le cause del problema e quali le sue implicazioni.

Prima di descrivere passo passo come porre rimedio, cerchiamo di fare chiarezza sul significato di questo messaggio, di capire quali siano le cause del problema e quali le sue implicazioni.

Google ora va oltre il contenuto testuale

Come è evidente ormai da parecchio tempo, Google presta sempre più attenzione non solo al contenuto testuale delle pagine Web, ma anche al loro aspetto grafico ed alla loro capacità di adattarsi ai dispositivi mobili, penalizzando nel posizionamento tra i risultati di ricerca i siti non responsive.

Proprio per questo, a partire dallo scorso marzo, gli spider di Google, che analizzano continuamente il contenuto del Web, hanno iniziato a renderizzare le pagine così come farebbe un comune browser, e non più limitandosi a prendere in considerazione il solo testo.

D’altronde, il colosso di Mountain View ha più volte, negli ultimi due anni, esplicitamente sollecitato i webmaster a rendere i propri siti ‘mobile friendly‘, ed ha anche suggerito di rimuovere eventuali blocchi ai file che ne gestiscono l’aspetto grafico (in particolare i CSS).

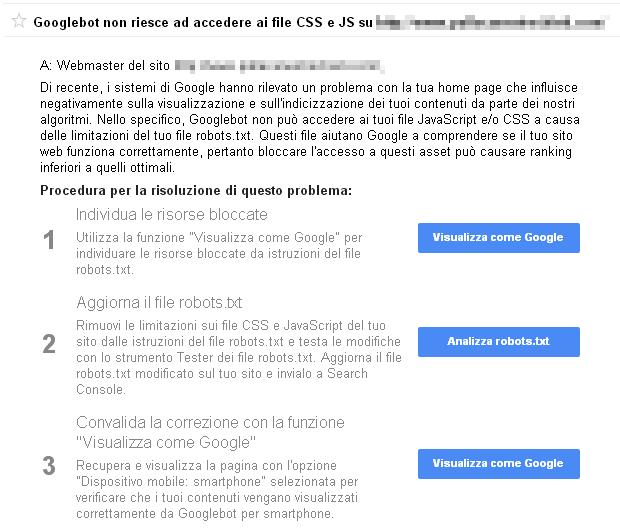

Il messaggio ricevuto in questi giorni dai webmaster, è dunque una sorta di ‘ultima chiamata’ per coloro che non si sono ancora adeguati alle nuove linee guida, e che per evitare penalizzazioni nel ranking da parte del motore di ricerca, devono opportunamente assecondare le richieste di Google.

Perchè Google non riesce ad accedere

Dal punto di vista tecnico, il problema deriva dalla configurazione non ottimale del file di testo ‘robots.txt’, che dovrebbe essere presente nella root del sito.

Questo file è normalmente utilizzato per gestire la visibilità dei diversi contenuti del sito agli spider dei motori di ricerca, specificando a quali file possano accedere e a quali invece no; il problema riportato da Google nasce proprio dal fatto che il file robots.txt contiene evidentemente qualche limitazione di troppo, e di conseguenza per rimediarvi bisognerà applicarvi le opportune modifiche.

I siti realizzati con i vari CMS (come WordPress, Drupal e soprattutto Joomla) compilano automaticamente il file robots.txt in base a quelle che reputano le impostazioni ideali, ma finendo spesso, appunto, per impedire l’accesso ai motori di ricerca a contenuti che essi giudicano invece essenziali.

Come modificare il file robots.txt

Fatta questa lunga premessa, vediamo in concreto come porre rimedio: innanzitutto bisogna creare una copia sul PC del file robots.txt (che come detto si trova nella directory principale del sito), in modo da poterlo modificare in locale e poi sostituirlo.

Per far ciò possiamo servirci di un qualsiasi client FTP e semplicemente scaricare il file in questione dal server, ricordandoci di conservare una copia di backup fino alla risoluzione del problema.

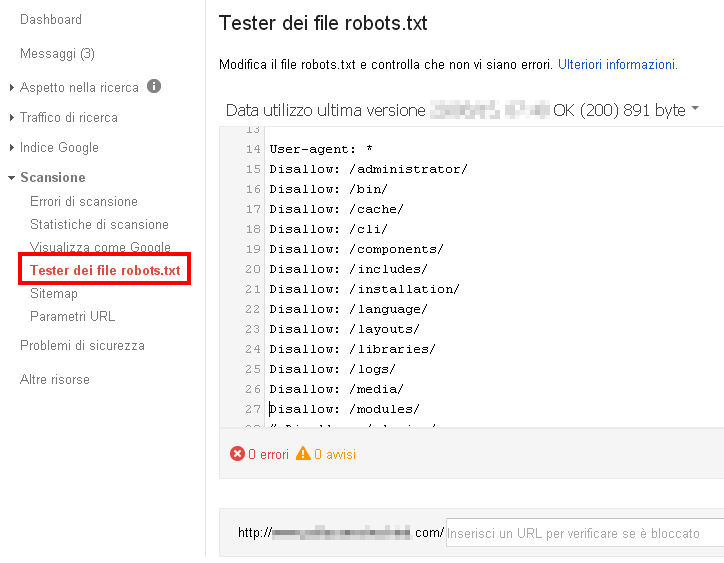

Una volta aperto il file con un editor di testo, si noterà la sua semplice struttura: le prime righe, precedute dal simbolo ‘#’ sono dei commenti che non influenzano in alcun modo il funzionamento del sito; a seguire è presente la riga ‘ User-agent: * ‘ che specifica per quali spider siano valide le istruzioni successive (il simbolo ‘asterisco’ indica che sono valide per qualsiasi bot).

Sotto compaiono i comandi ‘Disallow:’ ed ‘Allow:’ seguiti dall’indirizzo di un file o di una directory, che come è facilmente intuibile specificano se le risorse indicate saranno accessibili o meno agli spider dei motori di ricerca.

Se abbiamo ricevuto la segnalazione da parte di Google circa l’impossibilità di accedere ai file CSS e JS è proprio perché uno o più comandi ‘Disallow:’ bloccano l’accesso a tali contenuti, e di conseguenza vanno rimossi o modificati.

Va precisato che l’opzione di default è ‘Allow:’ e di conseguenza tutte le directory per le quali non viene specificato diversamente (‘Disallow:’) sono accessibili agli spider. In caso di conflitto tra i due istruzioni viene applicata quella più specifica, così nel caso di:

- Disallow: /cartella/

- Allow: /cartella/sottocartella/

ai bot verrà inibito l’accesso alla directory ‘/cartella/’ ed a tutte le sue sottodirectory, con l’eccezione di ‘/sottocartella/’, poiché in questo caso il comando ‘Disallow:’ è più generico di ‘Allow:’, che si riferisce, appunto, ad una sottocartella specifica.

Si potrebbe quindi pensare di eliminare semplicemente qualsiasi blocco lasciando al file robots.txt le sole righe:

- User-agent: *

- Disallow:

ma ciò, pur risolvendo effettivamente il problema, porterebbe ad indicizzare tutti i contenuti del sito, anche quelli inutili o che non desideriamo indicizzare, ed è quindi preferibile agire in modo più selettivo.

Come verificare il file robots.txt da Google Search Console

Purtroppo non sempre è facile intuire, dal semplice esame del file robots.txt, quali istruzioni siano responsabili del blocco lamentato da Google e come debbano essere modificate.

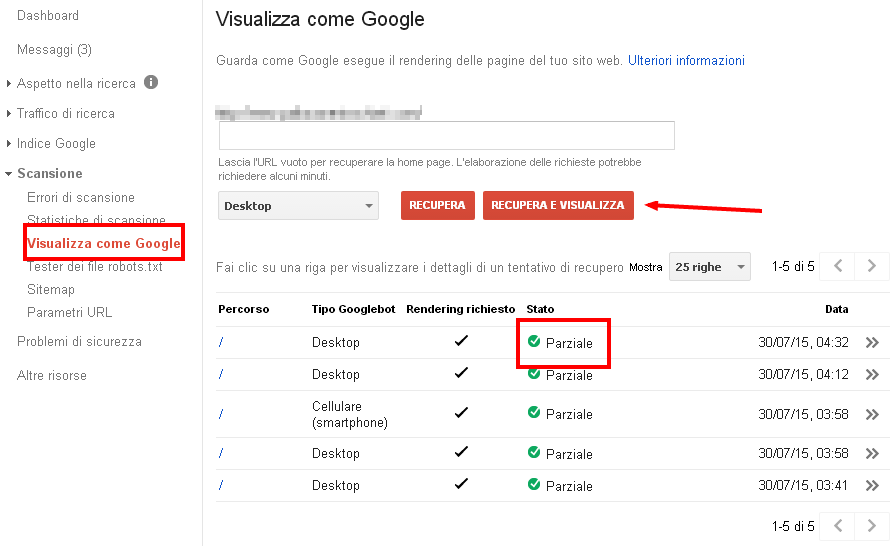

Possiamo però ricorrere in questo caso ai servizi messi a disposizione da Google stessa in Google Search Console, ed in particolare allo strumento ‘Visualizza Come Google’ (accessibile dal menu ‘Scansione’), nella cui finestra è mostrato il nostro sito così come appare a GoogleBot ed a fianco come appare ad un qualsiasi visitatore, in modo da evidenziare le differenze.

Una volta individuati quelli relativi a fogli di stile (.css) ed agli script (.js) è possibile cliccare su ‘Tester dei file robots.txt’, così da accedere ad una copia del file robots.txt presente sul server del nostro sito, con evidenziata in rosso la specifica istruzione che impedisce a Google l’accesso al relativo contenuto, e sulla quale bisognerà quindi intervenire.

A questo punto, a seconda dei casi, possiamo scegliere se rimuovere semplicemente il ‘Disallow:’ o se operare più selettivamente, aggiungendo un ‘Allow:’ per le sottocartelle contenenti i file bloccati (o per il singolo file).

Ottimizzare il file robots.txt con WordPress

Possiamo fare un esempio prendendo in considerazione un caso piuttosto frequente, che riguarda chi ha realizzato il proprio sito servendosi di WordPress. In questo caso, il file robots.txt contiene di default la riga:

- Disallow: /wp-content/

poiché solitamente non si intende indicizzare il contenuto di tale directory; tuttavia, la cartella potrebbe contenere altresì i fogli di stile (.css) che determinano l’aspetto del sito e che devono essere quindi assolutamente sbloccati. Per far ciò sarà sufficiente aggiungere un ‘Allow:’ per ogni sottocartella contenente i file .css e .js segnalati da Google, modificando ad esempio robots.txt in questo modo:

- Disallow: /wp-content/

- Allow: /wp-content/plugins/

nel caso i file da sbloccare si trovassero nella sottocartella /plugins/. In questo modo verrebbe bloccato tutto il contenuto della cartella /wp-content/ ad eccezione della sottocartella /plugins/.

Come salvare il file robots.txt nel server

Le modifiche apportate attraverso lo strumento ‘Tester del file robots.txt’ non saranno ovviamente applicate realmente al file robots.txt presente sul server del nostro sito, ma consentono di simulare i cambiamenti fino a raggiungere la configurazione ottimale.

Dopo aver sostituito il file, è consigliabile accedere nuovamente a Google Search Console, così da verificare che effettivamente non siano più riportati errori.

E tu, hai ricevuto il messaggio “Googlebot non riesce ad accedere ai file CSS e JS“? Hai risolto subito il problema oppure sei ancora in fase di attesa?

Facci sapere nei commenti che metodo hai utilizzato e in che modo hai modificato il file robots.txt.

Lascia un commento